Dec 18, 2025

Faradilla A.

5menit Dibaca

Ollama memungkinkan Anda menjalankan berbagai large language model (LLM) di server pribadi atau sistem lokal untuk membuat AI agent pribadi. Sebagai contoh, Anda bisa mengonfigurasinya dengan DeepSeek R1, model AI yang populer berkat keakuratan dan biayanya yang terjangkau.

Di artikel ini, kami akan menjelaskan cara menggunakan DeepSeek dengan Ollama. Kami akan memberikan panduannya langkah demi langkah, mulai dari penginstalan platform hingga pengaturan obrolan sesuai kebutuhan penggunaan Anda. Mari mulai!

Sebelum mengonfigurasikan Ollama, pastikan Anda sudah menyiapkan platform VPS Linux yang akan kita gunakan untuk menghosting AI agent. Apabila ingin menginstalnya secara lokal, Anda bisa menggunakan komputer pribadi dengan sistem operasi Linux.

Mana pun yang Anda pilih, sistem Anda harus memenuhi persyaratan hardware minimum. Karena platform AI seperti Ollama membutuhkan resource yang besar, spesifikasi minimum yang Anda butuhkan mencakup:

Untuk sistem operasi, Anda bisa menggunakan distribusi Linux populer seperti Ubuntu dan CentOS. Pastikan Anda menggunakan versi terbaru untuk menghindari masalah kompatibilitas dan keamanan.

Apabila tidak memiliki sistem yang memenuhi persyaratan di atas, Anda bisa mendapatkannya di Hostinger. Dengan harga mulai dari Rp145900.00/bulan, paket VPS KVM 4 kami menawarkan 4 core CPU, RAM 16 GB, dan penyimpanan SSD NVMe 200 GB.

VPS kami juga menyediakan berbagai template OS untuk menginstal aplikasi dengan mudah, termasuk Ollama. Anda pun tidak perlu melakukan proses setup yang ribet dan lama, apalagi kalau masih pemula.

Selain itu, VPS Hostinger memiliki asisten AI bawaan, Kodee, yang bisa membantu menyelesaikan masalah atau memandu Anda mengelola server. Dengan menggunakan prompt, Anda bisa memintanya untuk memeriksa sistem atau menuliskan perintah untuk berbagai kebutuhan.

Setelah selesai menyiapkan persyaratan di atas, ikuti langkah-langkah berikut untuk menginstal Ollama di Linux.

Klien Hostinger bisa menginstal Ollama dengan mudah menggunakan template yang dipilih pada proses onboarding atau di menu Sistem Operasi hPanel.

Apabila tidak memilih template, Anda harus menggunakan perintah. Buat koneksi ke server melalui SSH menggunakan PuTTY atau Terminal. Kalau ingin menginstal Ollama secara lokal, lewati langkah ini dan cukup buka terminal sistem Anda.

Penting! Apabila Anda menggunakan distro berbasis Red Hat Enterprise Linux seperti CentOS atau AlmaLinux, ganti apt dengan dnf.

Setelah tersambung, ikuti langkah-langkah berikut untuk menginstal Ollama:

sudo apt update

sudo apt install python3 python3-pip python3-venv

curl -fsSL https://ollama.com/install.sh | sh

python3 -m venv ~/ollama-webui && source ~/ollama-webui/bin/activate

pip install open-webui

screen -S Ollama

open-webui serve

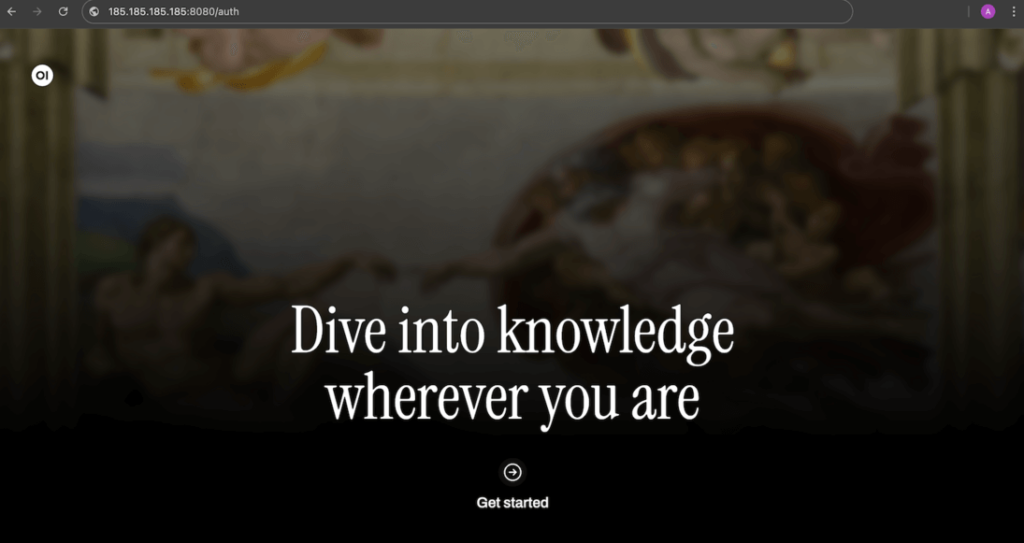

Selesai! Sekarang, Anda bisa mengakses Ollama dengan memasukkan alamat berikut ini di browser web. Jangan lupa untuk mengganti 185.185.185.185 dengan alamat IP VPS Anda yang sebenarnya:

185.185.185.185:8080

Setelah memastikan Ollama bisa berjalan dengan baik, mari kita konfigurasikan LLM DeepSeek R1. Kembali ke command-line interface sistem host Anda dan tekan Ctrl + C untuk menghentikan Ollama.

Apabila Anda menginstal Ollama menggunakan template OS Hostinger, cukup buat koneksi ke server Anda melalui SSH. Cara termudah untuk melakukannya adalah dengan menggunakan Terminal browser.

Kemudian, jalankan perintah ini untuk mendownload model Deepseek R1. Kami akan menggunakan versi 7b:

ollama run deepseek-r1:7b

Apabila Anda perlu menggunakan versi lain, seperti 1.5b, cukup ubah perintahnya. Untuk mempelajari lebih lanjut tentang perbedaan dan persyaratan setiap versi, lihat library DeepSeek Ollama.

Tunggu hingga sistem Anda selesai mendownload DeepSeek. Karena file LLM ini berukuran sekitar 5 GB, prosesnya mungkin akan cukup lama, tergantung pada kecepatan internet Anda.

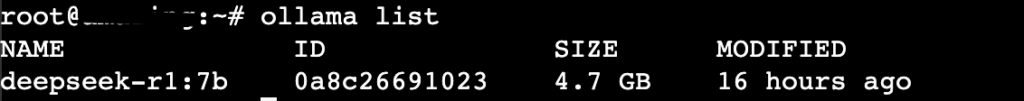

Setelah download selesai, tekan Ctrl + d untuk kembali ke shell utama. Kemudian, jalankan perintah berikut untuk memeriksa apakah DeepSeek telah dikonfigurasi dengan benar:

ollama list

Apabila Anda melihat DeepSeek dalam daftar LLM Ollama, artinya konfigurasi Anda berhasil. Sekarang, mulai ulang antarmuka web:

open-webui serve

Akses GUI Ollama Anda dan buat akun baru. Pengguna ini akan menjadi administrator default untuk AI agent Anda.

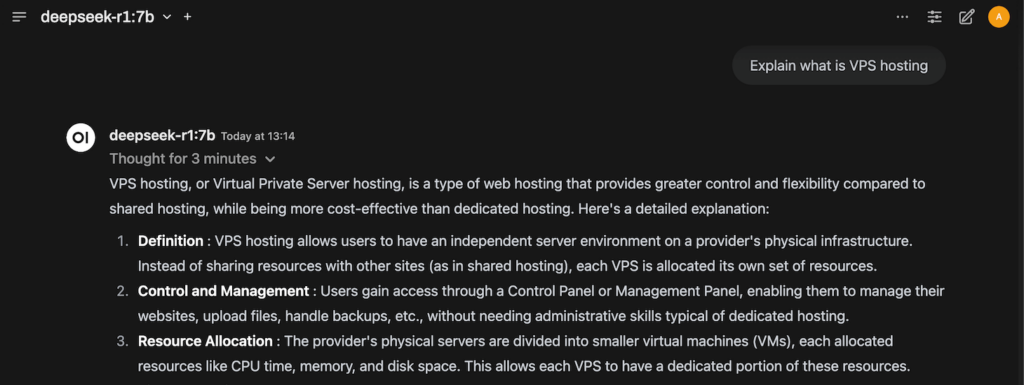

Setelah masuk, Anda akan melihat panel data utama tempat Anda bisa berinteraksi dengan DeepSeek. Mulailah mengobrol untuk memastikan LLM sudah berfungsi dengan baik.

Sebagai contoh, Anda bisa bertanya, “Explain what is VPS hosting.” Apabila DeepSeek bisa menjawabnya, berarti LLM dan AI agent Anda bekerja sebagaimana mestinya.

Tergantung pada koneksi internet dan penggunaan resource host, waktu yang dibutuhkan DeepSeek untuk memberikan respons akan berbeda-beda.

Meskipun Ollama dan DeepSeek bekerja tanpa masalah menggunakan konfigurasi default, Anda bisa menyempurnakan pengaturan obrolan sesuai dengan kebutuhan penggunaan Anda.

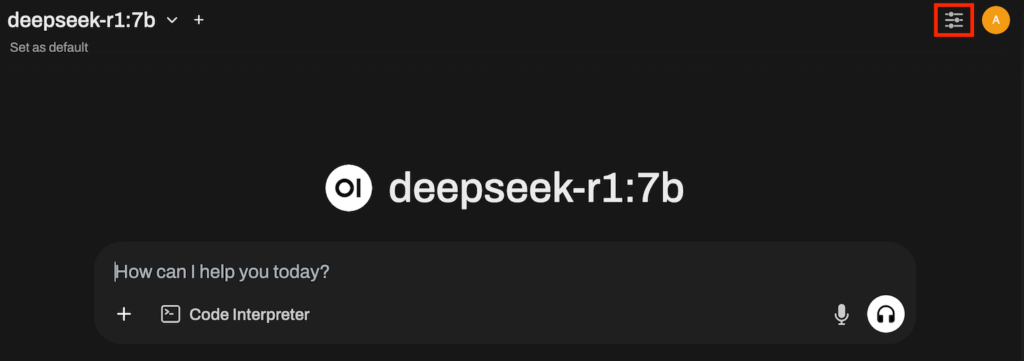

Untuk mengakses menu ini, klik ikon slider di bagian kanan atas dashboard Ollama, di samping ikon profil. Di bawah bagian Advanced Params, Anda bisa menyesuaikan berbagai pengaturan, termasuk:

Sebagai contoh, mengatur nilai Temperature yang lebih tinggi bisa sangat membantu apabila Anda menggunakan DeepSeek untuk menulis cerita fiksi. Sebaliknya, Anda mungkin perlu menurunkannya dan menaikkan Reasoning effort untuk menghasilkan kode.

Apabila ingin mempelajari lebih lanjut tentang pengaturan, menu, dan konfigurasi Ollama, Anda bisa membaca artikel kami tentang tutorial Ollama GUI.

Ollama adalah platform untuk menjalankan berbagai LLM di server atau komputer lokal untuk membuat AI agent pribadi. Melalui artikel ini, kami sudah menjelaskan cara menggunakan DeepSeek, model AI yang belakangan ini sangat populer, dengan Ollama.

Untuk menyiapkannya, Anda membutuhkan sistem Linux dengan minimal 4 inti CPU, RAM 16 GB, dan ruang penyimpanan 12 GB. Setelah persyaratan ini terpenuhi, instal Ollama dan Open WebUI menggunakan template OS Hostinger atau perintah.

Download DeepSeek untuk Ollama melalui command-line. Setelah selesai, mulai platform ini dengan menjalankan open-webui serve. Kemudian, akses dashboard platform menggunakan IP host dan port 8080.

Untuk meningkatkan respons Ollama berdasarkan kebutuhan penggunaan Anda, edit parameter pengaturan obrolan. Selain itu, gunakan teknik prompting AI yang tepat untuk meningkatkan kualitas jawaban DeepSeek.

Untuk menjalankan DeepSeek dengan Ollama, Anda membutuhkan sistem host Linux dengan minimal 4 core CPU, RAM 16 GB, dan ruang penyimpanan 12 GB. Anda bisa menggunakan distro populer seperti Ubuntu dan CentOS untuk sistem operasinya. Jangan lupa, gunakan versi OS terbaru untuk menghindari masalah kompatibilitas dan keamanan.

DeepSeek adalah LLM yang dikenal berkat efisiensi dan biayanya yang lebih terjangkau daripada model populer lainnya seperti OpenAI o1, namun dengan tingkat akurasi yang serupa. Menggunakannya dengan Ollama memungkinkan Anda membuat AI agent pribadi yang terjangkau dengan memanfaatkan kemampuan LLM ini.

Secara teori, Anda bisa menginstal Ollama dan menjalankan DeepSeek pada versi Ubuntu apa pun. Namun, sebaiknya gunakan versi sistem operasi yang lebih baru, seperti Ubuntu 20.04, 22.04, dan 24.04 karena risiko masalah kompatibilitas dan keamanan yang lebih rendah.

Semua konten tutorial di website ini telah melalui peninjauan menyeluruh sesuai standar dan komitmen editorial Hostinger.