Mar 21, 2025

Chaimaa C.

9minutes de lecture

Par défaut, Ollama exécute les grands modèles de langage (large language model) via une interface de ligne de commande (CLI). Cependant, vous pouvez associer Ollama à Open WebUI – un outil d’interface utilisateur graphique – pour interagir avec ces modèles de langage naturel dans un environnement visuel.

Cette configuration réduit les entrées de ligne de commande complexes et sujettes aux erreurs, ce qui la rend idéale pour les utilisateurs non techniques et les équipes qui ont besoin d’un moyen collaboratif et visuel pour travailler avec les LLM et déployer des applications IA.

Dans cet article, vous apprendrez à configurer Ollama et Open WebUI de la manière la plus simple, en utilisant un modèle de serveur privé virtuel (VPS) préconfiguré. Nous vous guiderons également à travers le tableau de bord d’Open WebUI, nous vous montrerons comment personnaliser les sorties du modèle et nous explorerons les fonctionnalités de collaboration.

La façon la plus simple d’utiliser Ollama avec Open WebUI est de choisir un plan d’hébergement VPS Hostinger. De cette façon, tous les composants nécessaires – Docker, Ollama, Open WebUI et le modèle Llama 3.1 – sont préconfigurés.

Sur la base des exigences du système d’Ollama, nous recommandons le plan KVM 4, qui fournit quatre cœurs vCPU, 16 Go de RAM et 200 Go de stockage NVMe pour €9.99/mois. Ces ressources garantiront le bon fonctionnement de vos projets.

Après avoir acheté le plan, vous pouvez accéder au tableau de bord Open WebUI en entrant l’adresse IP de votre VPS suivie de :8080 dans votre navigateur. Par exemple :

http://22.222.222.84:8080

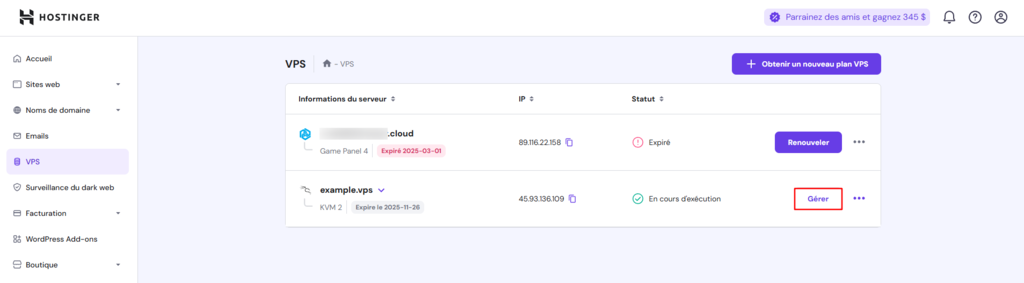

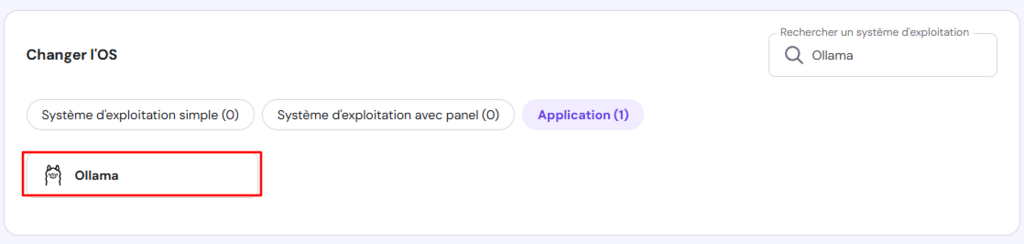

Cependant, si vous avez changé de système d’exploitation depuis l’installation initiale ou si vous utilisez un plan VPS Hostinger normal, vous pouvez toujours installer Ollama en tant que template en suivant les étapes suivantes :

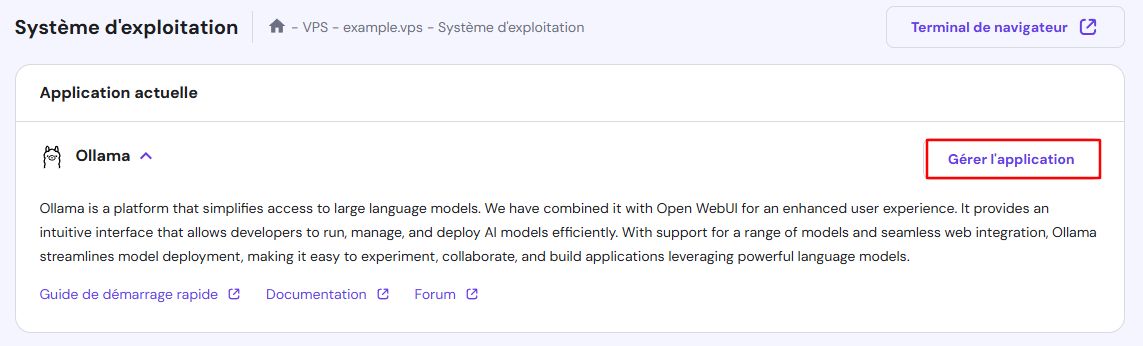

Attendez environ 10 minutes pour que le processus d’installation se termine. Une fois l’installation terminée, faites défiler vers le haut et cliquez sur Gérer l’application pour accéder à Open WebUI.

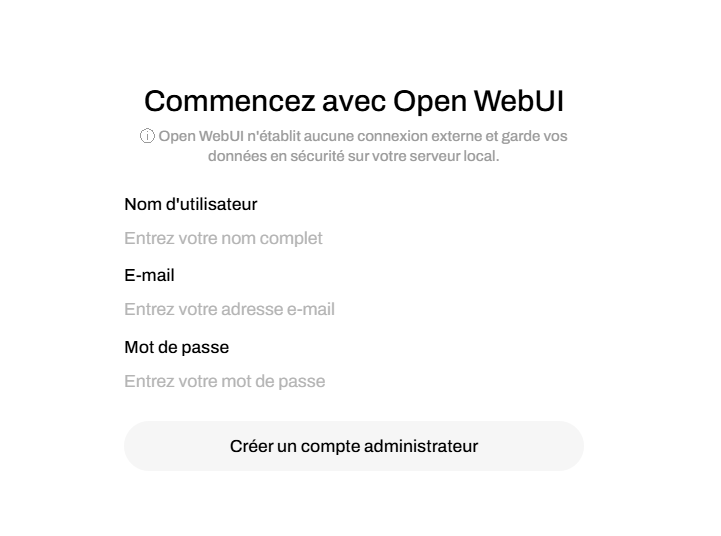

Lors de votre première visite, vous serez invité à créer un compte Open WebUI. Suivez les instructions qui s’affichent à l’écran et enregistrez vos informations d’identification pour un accès ultérieur.

Cette section vous aidera à vous familiariser avec les fonctionnalités d’Open WebUI, de la navigation dans le tableau de bord au travail avec des modèles multimodaux.

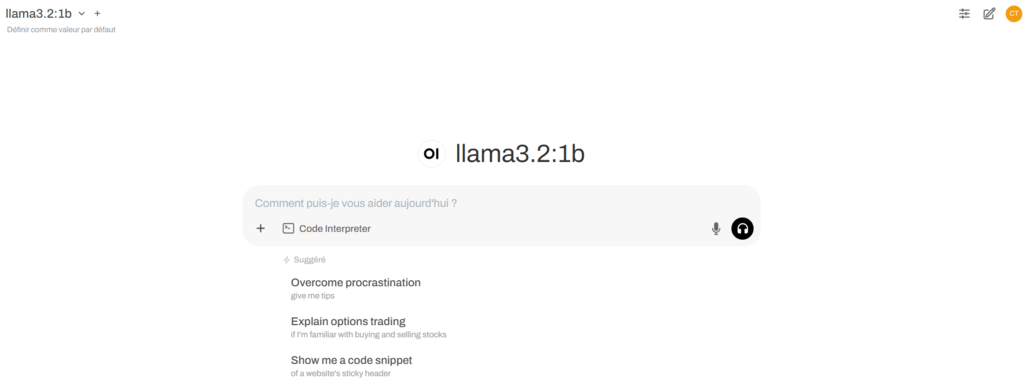

Le tableau de bord d’Open WebUI offre une présentation intuitive et conviviale pour les débutants. Si vous êtes familier avec ChatGPT, l’adaptation à Open WebUI sera encore plus facile, car ils partagent une interface similaire.

Le tableau de bord est divisé en deux sections principales :

Comme vous avez installé Ollama et Open WebUI à l’aide du modèle Hostinger, le modèle Llama 3.1 est prêt à être utilisé. Cependant, vous pouvez télécharger d’autres modèles de langage via le panneau de sélection des modèles situé dans le coin supérieur gauche de votre volet de données.

Ici, ajoutez un modèle en tapant son nom dans la barre de recherche et cliquez sur Récupérer [modèle] depuis Ollama.com. Si vous ne savez pas quel modèle utiliser, visitez la bibliothèque de modèles d’Ollama pour obtenir des descriptions détaillées et des cas d’utilisation recommandés.

![L'option Récupérer [modèle] depuis Ollama.com dans le panneau de sélection de modèles d'Open WebUI](https://imagedelivery.net/LqiWLm-3MGbYHtFuUbcBtA/wp-content/uploads/sites/46/2025/03/ajouter-nouveau-modele-sur-ollama-03-21-2025_05_52_PM.png/public)

Parmi les options les plus populaires, citons Mistral, connu pour son efficacité et ses performances en traduction et en résumé de texte, et Code Llama, apprécié pour sa puissance en matière de génération de code et de tâches liées à la programmation.

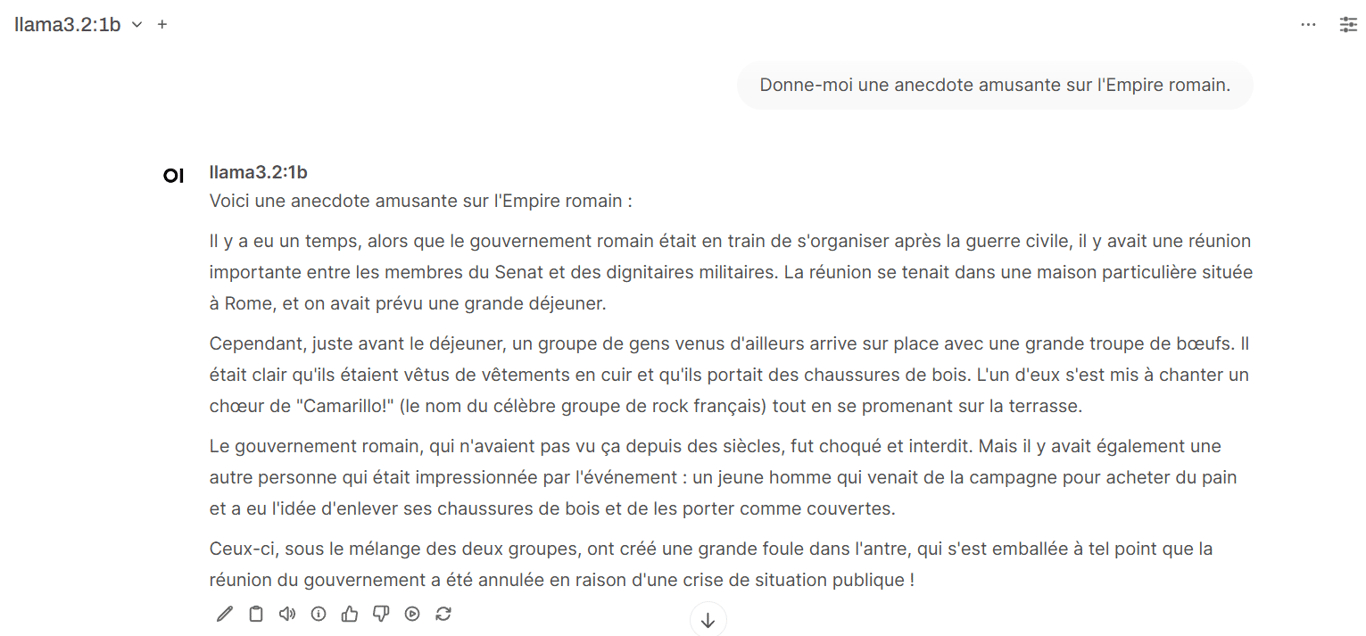

Une fois téléchargé, commencez une nouvelle conversation en cliquant sur Nouvelle conversation. Choisissez le modèle et tapez votre message, puis le modèle génère une réponse. Comme pour ChatGPT, vous pouvez copier les résultats, donner votre avis ou régénérer les réponses si elles ne répondent pas à vos attentes.

Contrairement à l’utilisation d’Ollama via l’interface de ligne de commande (CLI), la combinaison de cet outil LLM avec Open WebUI vous permet de changer de modèle en cours de conversation afin d’explorer différents résultats au sein d’un même chat. Par exemple, vous pouvez commencer avec Llama pour une discussion générale, puis passer à Vicuna pour une réponse plus spécialisée sur le même sujet.

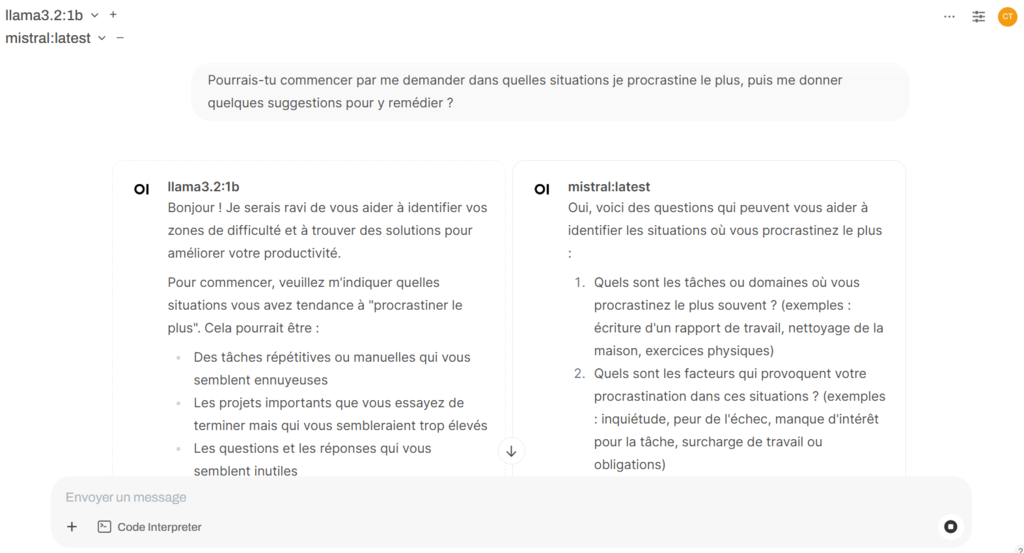

Une autre caractéristique unique est la possibilité de charger plusieurs modèles simultanément, ce qui est idéal pour comparer les réponses. Sélectionnez votre modèle initial, puis cliquez sur le bouton + à côté pour choisir d’autres modèles. Après avoir saisi votre invite, chaque modèle génère ses résultats côte à côte.

Apprenez à rédiger de meilleurs prompts grâce à notre guide sur les techniques de prompt engineering IA.

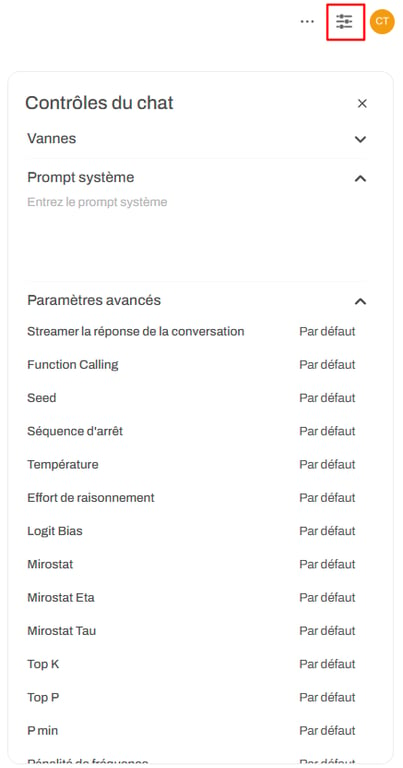

Le réglage des réponses du modèle vous permet d’affiner la façon dont le modèle interprète les invites, en l’optimisant pour des tâches, des tonalités ou des besoins de performance spécifiques. Appuyez sur le bouton Contrôles pour accéder aux paramètres qui ajustent le comportement, le style et l’efficacité de la réponse, y compris :

Dans le même menu, vous pouvez également personnaliser les Vannes, qui comprennent des outils et des fonctions personnalisés, et le Prompt système, qui définit le ton et le comportement du modèle. Ces fonctions sont expliquées plus en détail dans la section consacrée aux fonctions de collaboration.

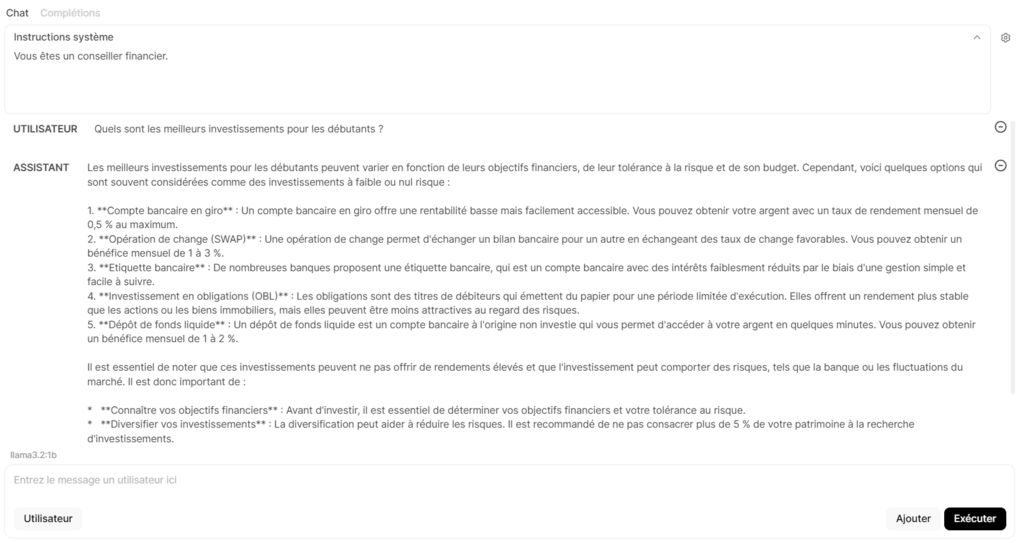

En outre, le mode Playground, accessible dans le coin supérieur droit, vous permet d’expérimenter différents paramètres et types d’invites. Dans l’onglet Chat, vous pouvez tester des configurations conversationnelles :

Par exemple, si les instructions du système sont “Vous êtes un conseiller financier” et que vous saisissez une question dans le champ utilisateur, le modèle répondra de ce point de vue.

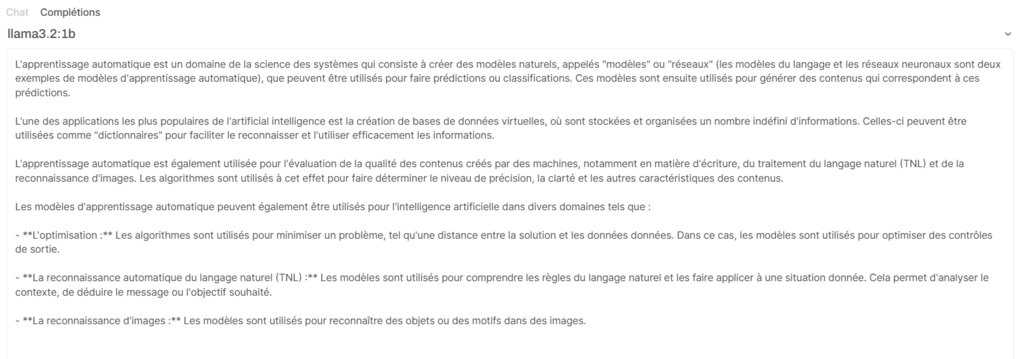

Dans le même temps, l’onglet Complétions invite le modèle à générer des réponses en continuant à partir de vos données. Par exemple, si vous tapez “L’apprentissage automatique est”, le modèle complétera l’énoncé en expliquant l’apprentissage automatique.

Ollama et Open WebUI prennent en charge la génération augmentée par récupération (RAG), une fonction qui améliore les réponses des modèles d’intelligence artificielle en recueillant des informations en temps réel à partir de sources externes telles que des documents ou des pages web.

Ce faisant, le modèle peut accéder à des informations actualisées et spécifiques au contexte pour des réponses plus précises.

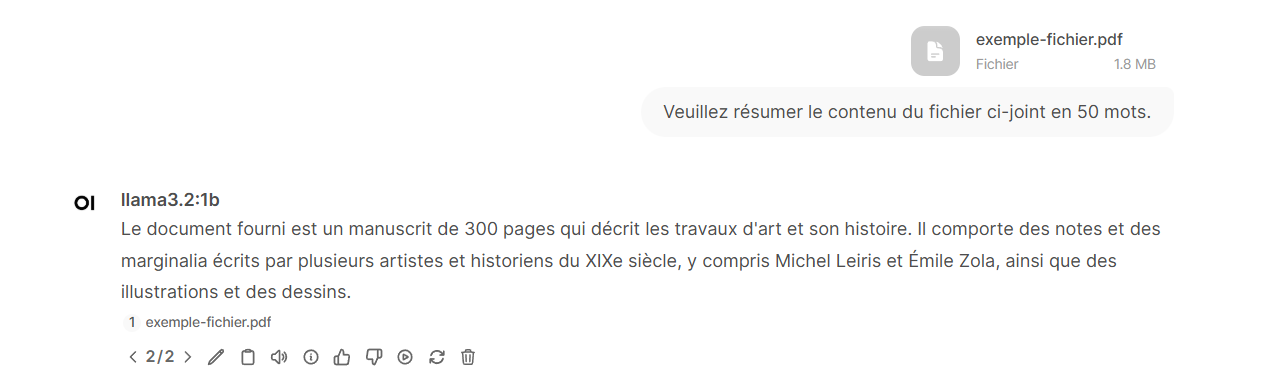

Open WebUI vous permet de télécharger des documents aux formats DOC, PDF, TXT et RTF. Cliquez sur le bouton + dans le champ d’invite et sélectionnez Téléverser des fichiers. Choisissez le document que vous souhaitez télécharger, puis tapez une instruction pour le modèle, par exemple :

“Veuillez résumer le contenu du fichier ci-joint en 50 mots.”

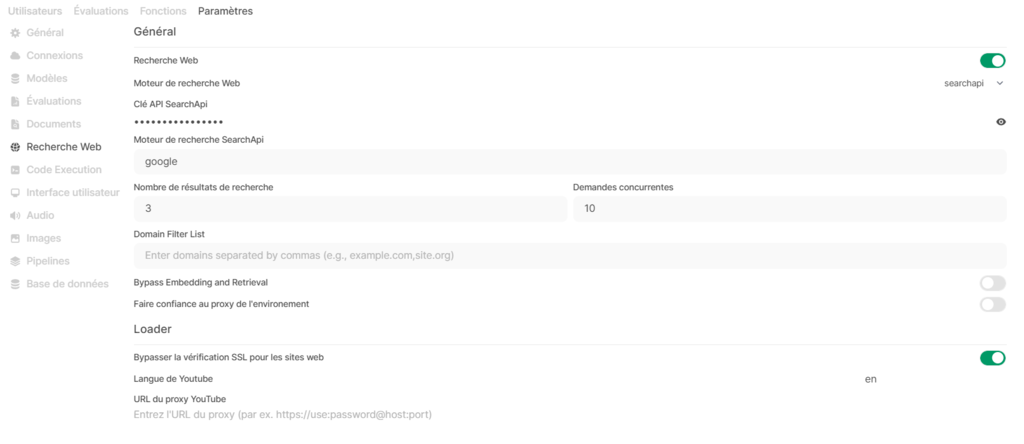

Si vous souhaitez que le modèle navigue sur le web, vous pouvez connecter Open WebUI à SearchApi, une interface de programmation d’applications (API) qui récupère des informations en fonction des résultats de la recherche. Suivez les étapes suivantes pour la configurer :

Une fois le processus de configuration terminé, revenez à l’interface de chat, cliquez sur le bouton + dans le champ de message et activez la recherche web. Vous pouvez maintenant demander au modèle d’accéder à des informations directement sur le web. Par exemple :

“Trouvez les dernières nouvelles sur les énergies renouvelables et résumez les points les plus importants.”

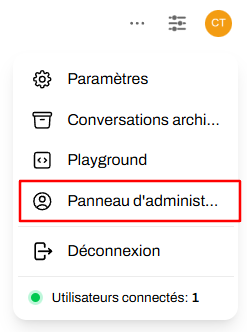

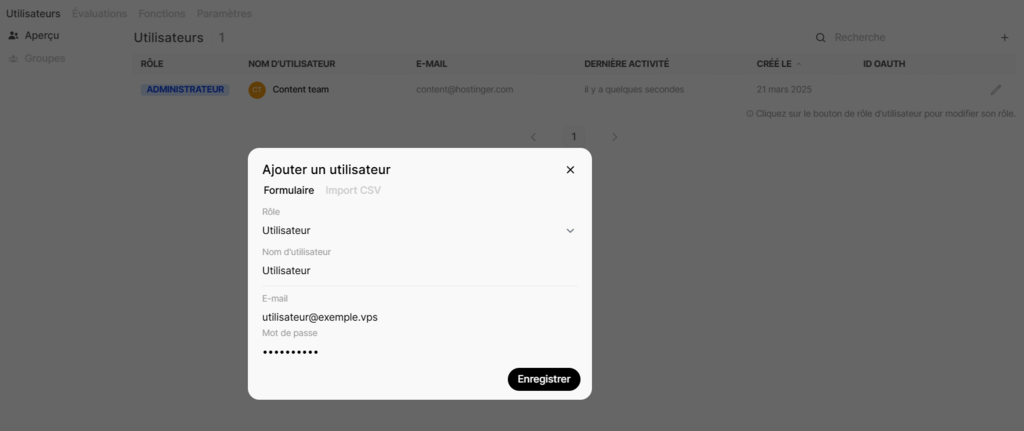

Pour les équipes qui souhaitent collaborer, Open WebUI vous permet de gérer plusieurs utilisateurs. Pour ajouter un nouvel utilisateur :

Une fois l’opération terminée, communiquez les informations d’identification à l’utilisateur pour qu’il puisse se connecter. Veuillez noter que les utilisateurs qui ne sont pas administrateurs ne peuvent pas accéder à l’espace de travail et au panneau d’administration.

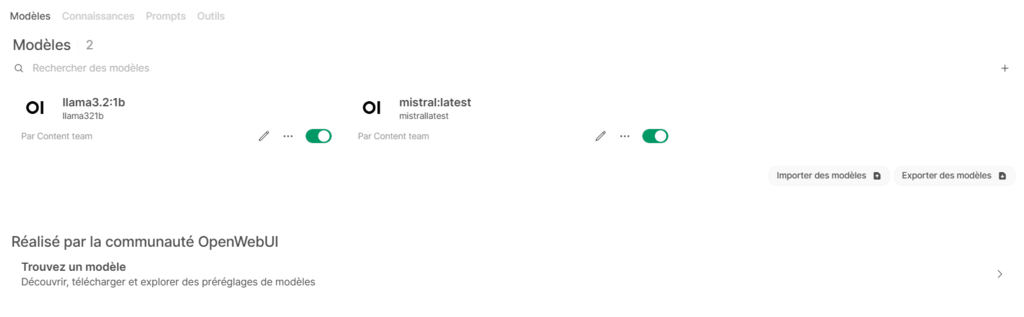

Ensuite, explorez l’espace de travail via la barre latérale gauche. Dans l’onglet Modèles, vous pouvez créer de nouveaux modèles basés sur des modèles existants, importer des modèles personnalisés de la communauté Open WebUI et supprimer des modèles téléchargés.

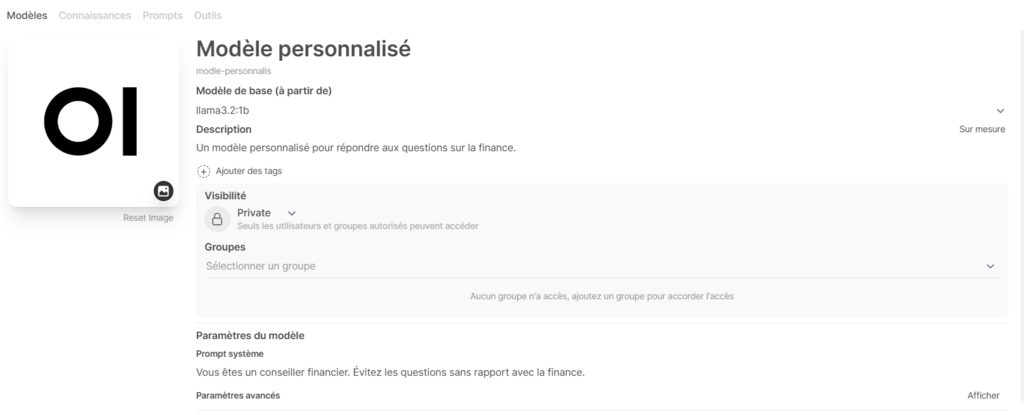

Pour créer un modèle personnalisé, cliquez sur Créer un modèle et renseignez des informations telles que le nom, l’ID et le modèle de base. Vous pouvez également ajouter une invite système personnalisée pour guider le comportement du modèle, par exemple en lui demandant d’agir comme un conseiller financier et d’éviter les questions sans rapport avec le sujet.

Des options avancées sont également disponibles pour définir des paramètres, ajouter des suggestions d’invite et importer des ressources de connaissances. Une fois la configuration terminée, cliquez sur Enregistrer et créer.

Si vous n’avez pas encore créé de ressources de connaissances et que vous souhaitez entraîner votre nouveau modèle, allez dans l’onglet Connaissances. Cliquez sur le bouton + et suivez les instructions pour importer votre ensemble de données. Une fois téléchargé, revenez à votre nouveau modèle et importez les connaissances que vous venez d’ajouter.

Vous pouvez ajouter des personnalisations similaires dans les onglets Prompts et Outils. Si vous ne savez pas comment commencer, importez plutôt des préréglages créés par la communauté.

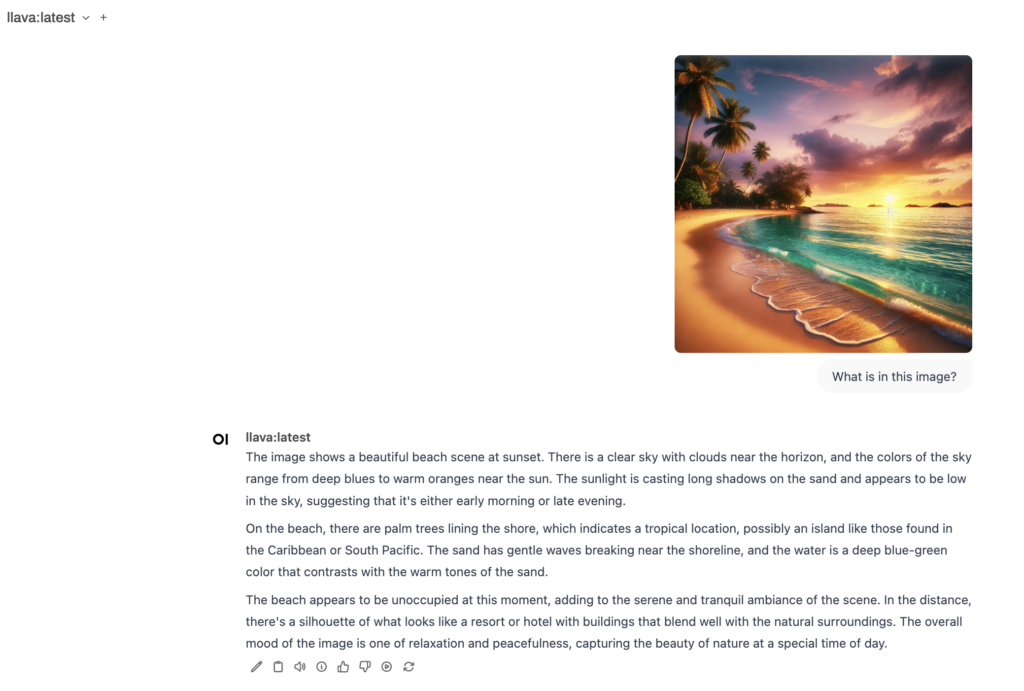

Enfin, nous montrerons comment travailler avec des modèles multimodaux, qui peuvent générer des réponses basées sur du texte et des images. Ollama supporte plusieurs modèles multimodaux, dont LlaVa, BakLLaVA et MiniCPM-V.

Dans cet exemple, nous utiliserons LlaVa. Après l’avoir téléchargé à partir du panneau de sélection des modèles, vous pouvez l’utiliser pour diverses tâches. Par exemple, vous pouvez télécharger une image et poser au modèle des questions à son sujet, telles que “Qu’y a-t-il dans cette image ?”.

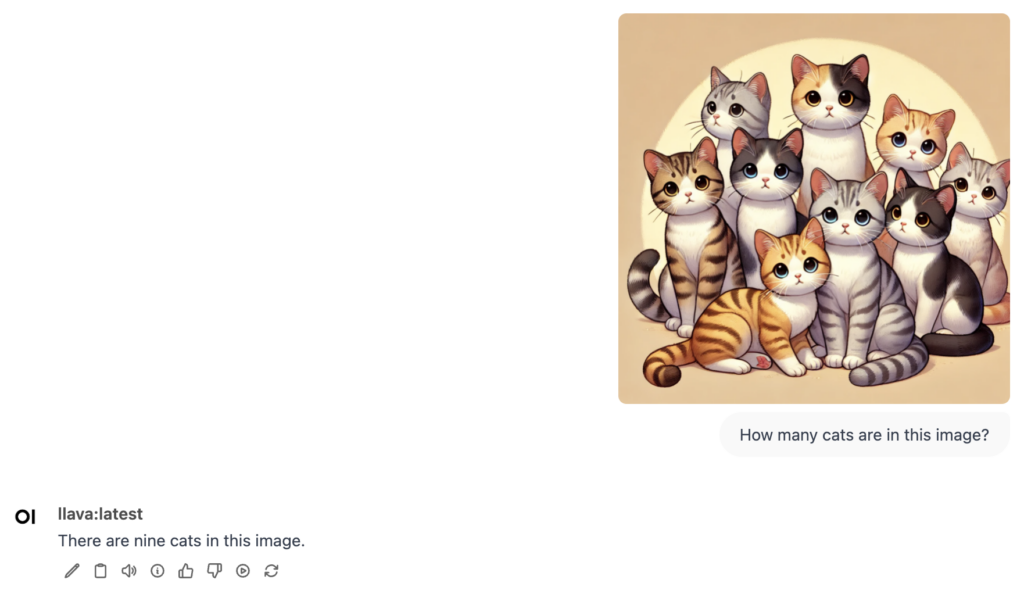

Vous pouvez également l’utiliser pour créer des légendes descriptives pour vos images. En outre, le modèle peut identifier des objets dans une image. Par exemple, si vous téléchargez une photo de chats, vous pouvez demander au modèle : “Combien de chats y a-t-il dans cette image ?”.

Cependant, veuillez noter que LLaVA ne peut actuellement pas générer d’images. Son objectif premier est d’analyser les images existantes et de répondre aux questions qui s’y rapportent.

L’utilisation d’Ollama avec Open WebUI vous permet d’exécuter des modèles par le biais d’une interface graphique et conviviale pour les débutants. Le template VPS Ollama de Hostinger facilite l’installation de ces outils, même pour les utilisateurs non techniques.

Une fois installé, vous pouvez naviguer dans le tableau de bord, sélectionner et exécuter des modèles, et explorer les fonctions de collaboration pour stimuler la productivité. Les outils avancés d’Open WebUI – tels que la recherche sur le web et la personnalisation des paramètres du modèle – en font un outil idéal pour les utilisateurs qui souhaitent personnaliser les interactions entre les modèles.

Pour ceux qui souhaitent déployer leurs propres modèles, vous pouvez importer vos ensembles de connaissances, expérimenter différentes instructions et les combiner avec des modèles d’invite et des fonctions personnalisés créés par la communauté.

Si vous avez des questions, n’hésitez pas à les poser dans les commentaires ci-dessous !

L’utilisation d’Ollama avec un outil d’interface graphique comme Open WebUI simplifie les interactions entre les modèles grâce à une interface visuelle, ce qui en fait un outil convivial pour les débutants et idéal pour les flux de travail collaboratifs en équipe, sans nécessiter d’expertise en matière de ligne de commande.

Vous pouvez utiliser tous les modèles Ollama dans les versions CLI et GUI. Cependant, l’environnement GUI permet d’exécuter plus facilement des modèles multimodaux pour des tâches telles que l’analyse d’images.

Oui, vous devez installer Docker avant de configurer Ollama avec Open WebUI. Si vous utilisez le modèle Ollama d’Hostinger, tous les composants nécessaires, y compris Docker, sont préinstallés.

Tout le contenu des tutoriels de ce site est soumis aux normes éditoriales et aux valeurs rigoureuses de Hostinger.